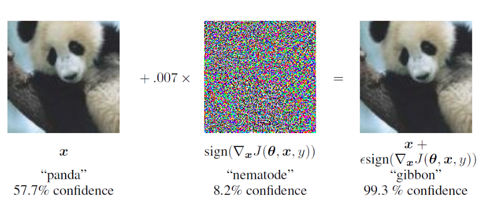

왼쪽 이미지는 학습된 모델의 입력으로 넣었을 때 판다로 나오지만, 가운데 이상한 사진을 섞어서 모델에 입력하면 우측과 같이 사람이 보았을땐 여전히 판다지만, 딥러닝의 결과로는 99.3% gibbon이라는 긴팔원숭이가 나옵니다. 위와 같이 원래의 입력에 임의의 노이즈를 추가해 의도적으로 결과를 바꾸는 것을 Adversarial Attack 이라고 하고, 반대로 의도적인 방해에 대응하여 인식에 방해되지 않도록 만드는 것을 Adversarial Defense라고 합니다. 딥러닝을 이용한 학습이 증가하면서, 딥러닝이 얼마나 믿을만한지 혹은 딥러닝이 얼마나 개선할 것이 많은지 에 대한 테스트에 관하여 진행한 논문이 있습니다. 해당 논문은 딥러닝에서 선형 모델로부터 풀어나갑니다. 쉽게, y=Wx 라는 함수를 떠올려..